(sophimania.pe – Perú).- En los últimos años, varios expertos como Stephen Hawking, Nick Bostrom, Elon Musk y Bill Gates, han advertido de los peligros que conlleva una Super Inteligencia Artificial (ASI), la cual, en teoría, podría poner en riesgo la hegemonía humana en el planeta y significaría el fin del mundo tal y como lo conocemos.

La amenaza, creen ellos, es tan real que incluso han llegado destinar dinero para una fundación llamada OpenAI, la cual está dedicada al desarrollo de la IA con el fin de beneficiar a la humanidad.

Pero para muchos, tales temores son exagerados. Como Andrew Ng de la Universidad de Stanford, quién también es científico en jefe del gigante chino de Internet Baidu. Ng cree que temer a un aumento de robots asesinos (que es la representación más usual del levantamiento de una ASI) es como preocuparse por la superpoblación en Marte.

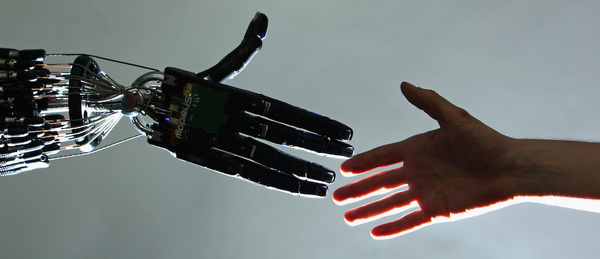

Sin embargo, esto no quiere decir que nuestra creciente dependencia de la IA no tenga riesgos reales. De hecho, esos riesgos ya existen. A medida que los sistemas inteligentes se involucran en decisiones cada vez más delicadas, existe el peligro de que partes importantes de nuestras vidas se estén haciendo sin un escrutinio suficiente.

Aún más, la IA podría tener efectos inesperados en ámbitos para los que aún no nos hemos preparado, como el cambio de nuestra relación con los médicos o la forma en que nuestros vecindarios son vigilados.

Por otro lado, otro de los riesgos que presenta la automatización (y de los que nadie habla) es que puede hacer que nos volvamos cada vez más torpes y dependientes. Por ejemplo, se espera que en un futuro todos los vehículos sean autónomos y los humanos ya no tengamos que manejarlos, pero ¿qué pasará cuando en algún momento el sistema falle y sea el humano quién tenga que asumir el control del auto?

En lugar de preocuparnos por un futuro levantamiento de las máquinas, el verdadero riesgo es que podemos confiar demasiado en los sistemas inteligentes que estamos construyendo. Recordemos que el aprendizaje automático funciona mediante la formación de software para detectar patrones de datos. Una vez entrenado, se pone a trabajar analizando datos frescos e invisibles. Pero cuando la computadora escupe una respuesta, típicamente no podemos ver cómo es que la maquina llegó a esa conclusión.

A medida que las IAs se despliegan para evaluar todo, desde la calificación crediticia hasta la idoneidad para un trabajo, se corre el riesgo de que se equivoquen. Y aunque la intuición humana no es infalible, en ocasiones tiene un componente de análisis que los sistemas inteligentes aún no tienen.

Dado que muchos de los datos con los que alimentamos a las IAs son imperfectos, no debemos esperar respuestas perfectas todo el tiempo. Reconocerlo es el primer paso en la gestión del riesgo. Los procesos de toma de decisiones construidos sobre las IAs necesitan ser más abiertos al escrutinio. Dado que estamos construyendo inteligencia artificial a nuestra propia imagen, es probable que termine siendo tan brillante o tonto como nosotros mismos.

Fuente: BBC